早年间, ⽀持多个⽤户并发访问的服务应⽤,往往采⽤多进程⽅式,即针对每⼀个 TCP ⽹络连接创建⼀个服务进程。在 2000 年左右,⽐较流⾏使⽤ CGI ⽅式编写 Web 服务,当时⼈们⽤的⽐较多的 Web 服务器是基于多进程模式开发的 Apache1.3.x 系列,因为进程占⽤系统资源较多,所以⼈们开始使⽤多线程⽅式编写 Web 应用服务,线程占⽤的资源更少,这使单台服务器⽀撑的⽤户并发度提⾼了,但依然存在资源浪费的问题。因为在多进程或多线程编程⽅式下,均采⽤了阻塞通信⽅式,对于慢连接请求,会使服务端的进程或线程因『等待』客户端的请求数据⽽不能做别的事情,⽩⽩浪费了操作系统的调度时间和系统资源。这种⼀对⼀的服务⽅式在⼴域⽹的环境下显示变得不够廉价,于是⼈们开始采⽤⾮阻塞⽹络编程⽅式来提升服务端网络并发度,⽐较著名的 Web 服务器 Nginx 就是⾮阻塞通信服务的典型代表,另外还有象 Java Netty 这样的⾮阻塞⽹络开发库。

⾮阻塞⽹络编程⼀直以⾼并发和⾼难度⽽著称,这种编程⽅式虽然有效的提升了服务器的利⽤率和处理能力,但却对⼴⼤程序员提出了较⼤挑战,因为⾮阻塞 IO 的编程⽅式往往会把业务逻辑分隔的⽀离破碎,需要在通信过程中记录⼤量的中间状态,⽽且还需要处理各种异常情况,最终带来的后果就是开发周期⻓、复杂度⾼,⽽且难于维护。

阻塞式⽹络编程实现容易但并发度不⾼,⾮阻塞⽹络编程并发度⾼但编写难,针对这两种⽹络编程⽅式的优缺点,⼈们提出了使⽤协程⽅式编写⽹络程序的思想。其实协程本身并不是⼀个新概念,早在2000年前Windows NT 上就出现了『纤程』的 API,号称可以创建成千上万个纤程来处理业务,在 BSD Unix 上可以⽤来实现协程切换的 API <ucontext.h> 在 2002 年就已经存在了,当然另外⽤于上下⽂跳转的 API<setjmp.h> 出现的更早(1993年)。虽然协程的概念出现的较早,但⼈们终不能发现其广泛的应⽤场景,象『longjmp』这些 API 多⽤在⼀些异常跳转上,如 Postfix(著名的邮件MTA)在处理⽹络异常时⽤其实现程序跳转。直到 Russ Cox 在 Go 语⾔中加⼊了协程(Goroutine)的功能,使⽤协程进⾏⾼并发⽹络编程才变得的简单易⾏。

Russ Cox 早在 2002 年就编写了⼀个简单的⽹络协程库 libtask(https://swtch.com/libtask/ ),代码量不多,却可以使我们⽐较清晰地看到『通过使⽹络 IO 协程化,使编写⾼并发⽹络程序变得如此简单』。

More...

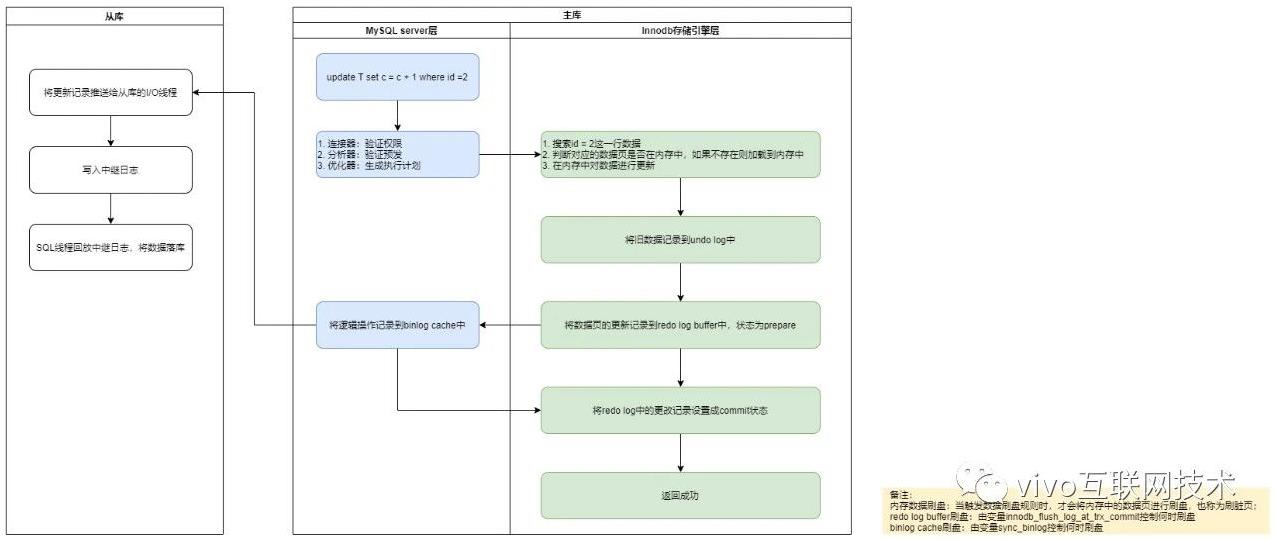

MySQL作为当下最流行的开源关系型数据库,有一个很关键和基本的能力,就是必须能够保证数据不会丢。那么在这个能力背后,MySQL是如何设计才能保证不管在什么时间崩溃,恢复后都能保证数据不会丢呢?有哪些关键技术支撑了这个能力?本文将为我们一一揭晓。

一、前言

MySQL 保证数据不会丢的能力主要体现在两方面:

- 能够恢复到任何时间点的状态;

- 能够保证MySQL在任何时间段突然奔溃,重启后之前提交的记录都不会丢失;

对于第一点将MySQL恢复到任何时间点的状态,相信很多人都知道,只要保留有足够的binlog,就能通过重跑binlog来实现。

对于第二点的能力,也就是本文标题所讲的crash-safe。即在 InnoDB 存储引擎中,事务提交过程中任何阶段,MySQL突然奔溃,重启后都能保证事务的完整性,已提交的数据不会丢失,未提交完整的数据会自动进行回滚。这个能力依赖的就是redo log和unod log两个日志。

More...

AI 前线导读:天下武功,唯快不破。伯克利 RISE 实验室推出了最新的键值存储数据库 Anna,提供了惊人的存取速度、超强的伸缩性和史无前例的一致性保证。Jeff Dean 说,当一个系统增长到十倍规模时,就需要进行重新设计。那么,对于 RISE 实验室的研究员们来说,怎样才能设计出一个具备指数级增长规模的键值存储数据库呢?

更多干货内容请关注微信公众号“AI 前线”,(ID:ai-front)

题外话:RISE 实验室的前身是赫赫有名的伯克利 AMP 实验室,该实验室曾开发出了一大批大获成功的分布式技术,这些技术对高性能计算产生了深远的影响,包括 Spark、Mesos、Tachyon 等。如今,原 AMP 实验室博士生,同时也是 Spark 和 Mesos 核心作者之一的 Matei 已经转身去了斯坦福,并于去年年底推出了以普及机器学习实践为目的的开源项目 DAWN(详见 AI 前线报道 ),而 RISE 实验室也在没多久后推出了志在取代 Spark 的新型分布式执行框架 Ray(详见 AI 前线报道)。

More...

HotDB是一款专注MySQL数据库服务的高可靠高吞吐量的分布式数据库产品,能在分布式数据环境下为应用提供集中式数据库的操作体验,为海量数据、海量用户、高可用、高性能和高并发的业务系统提供强有力的支撑,同时具备强分布式透明、易扩展、无学习成本等特点。让技术工程师专注应用程序编码实现,不必知道也不必关心数据的存放和操作位置等细节;让数据库运维人员更轻松地管理海量数据和大规模的数据库集群。

More...